Từ “con cưng” của Phố Wall, loạt cổ phiếu công nghệ hàng đầu nước Mỹ đang bị ghẻ lạnh sau cú sốc DeepSeek.

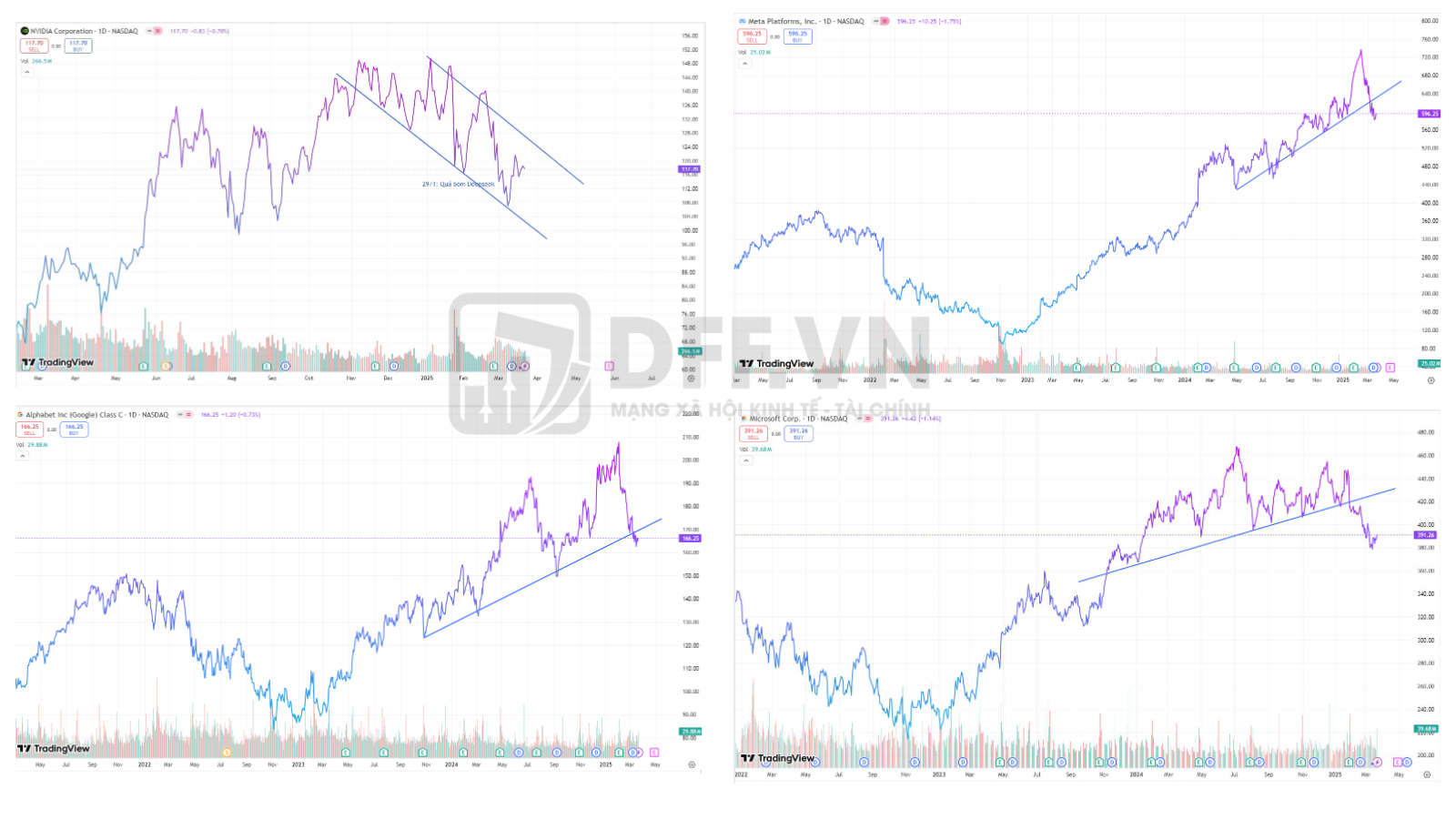

Diễn biến một số big tech tại Mỹ sau sự xuất hiện của DeepSeek (Nguồn: TradingView)

Đã gần 2 tháng sau khi mô hình AI “giá rẻ” của Trung Quốc ra mắt, cổ phiếu Nvidia vẫn chưa thể quay lại vùng đỉnh lịch sử (153,13 USD/cp), thậm chí còn tụt thêm 5% nữa.

Nổi lên như “ngọn cờ đầu” trong cơn sốt AI, cổ phiếu của gã khổng lồ công nghệ này chưa từng chứng kiến nhịp giảm lớn như vậy trong hai năm gần nhất.

Tương tự, cổ phiếu Microsoft, Alphabet hay Meta cũng rơi vào downtrend, lần lượt giảm 12,3%; 17% và 13% kể từ sau cú sốc DeepSeek.

Nhìn rộng ra, các cổ phiếu khác trong nhóm Magnificent Seven - tốp 7 công ty công nghệ hàng đầu nước Mỹ, gồm: Apple, Microsoft, Amazon, Alphabet, Tesla, Meta và Nvidia - cũng đang có diễn biến giao dịch ảm đạm.

“Rung chấn” cũng lan sang các cổ phiếu công nghệ Việt. Cổ phiếu FPT của CTCP FPT lao dốc từ vùng 150.000 đồng/cp, có lúc rơi sâu về sát 123.000 đồng/cp, với thanh khoản tăng vọt.

DeepSeek - ‘thiên nga đen’ làm nổ bong bóng AI?

Ngay sau khi ra mắt, DeepSeek R1 đã gây ấn tượng về sức mạnh vượt trội, không chỉ sánh ngang mà còn vượt qua các mô hình trí tuệ nhân tạo (AI) nổi tiếng của Mỹ, như: ChatGPT của OpenAI, Gemini của Google, Copilot của Microsoft hay Llama của Meta.

Đáng nói, sức mạnh của mô hình AI ‘made in China’ này được công nhận rộng rãi bởi các bên thứ ba độc lập, chứ không phải một thông điệp truyền thông chủ động của nhóm founder đằng sau nó - đứng đầu là doanh nhân 8x Lương Văn Phong (Liang Wenfeng).

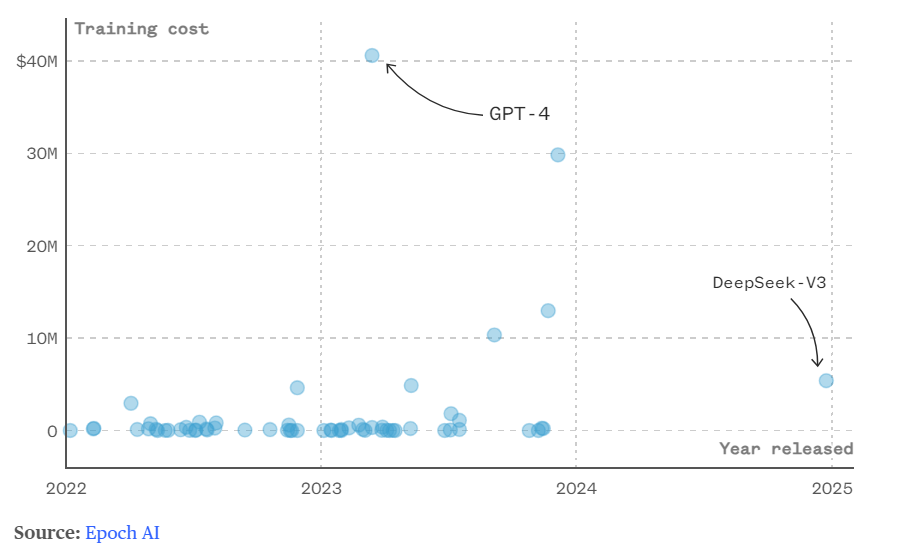

DeepSeek tiết kiệm chi phí training hơn hẳn so với ChatGPT (Nguồn: NBCNews)

DeepSeek cũng là minh chứng cho nên công nghệ đang bứt phá của Trung Quốc, giữa “thiên la địa võng” các rào cản mà Mỹ đặt ra.

Nó chứng minh rằng các mô hình AI có thể hoạt động hiệu quả trên các chip hiệu suất thấp, rẻ tiền, thay vì các con chip và GPU đắt đỏ của Nvidia. Điều này đe doạ trực tiếp tới vị thế thống trị của của gã khổng lồ công nghệ Mỹ.

Không dừng lại ở đó, OpenAI, Microsoft, Google và Meta cũng buộc phải tối ưu hóa mô hình hoạt động và chi phí vận hành nếu không muốn bị các đối thủ Trung Quốc vượt mặt trong cuộc đua AI. Khá trùng hợp, nhiều ông lớn công nghệ Mỹ cũng đang sa thải nhân sự quy mô lớn, bản chất là cắt giảm chi phí, sau sự xuất hiện của DeepSeek.

Các mô hình ngôn ngữ lớn (LLM) tại Trung Quốc sử dụng phần cứng rẻ hơn và kiến trúc mở để giảm chi phí, trong khi các mô hình LLM của Mỹ được đào tạo trên cụm GPU tiên tiến của NVIDIA. Do các biện pháp kiểm soát xuất khẩu, phần lớn LLM Trung Quốc phải dựa vào đào tạo phân tán trên các GPU hiệu năng thấp hơn.

Tuy nhiên, DeepSeek đã vượt qua những rào cản này nhờ hai giải pháp chính.

Thứ nhất, về kiến trúc mô hình, DeepSeek cải tiến cơ chế Attention thành Multi-head Latent Attention (MLA), giúp tiết kiệm bộ nhớ GPU.Họ cũng phát triển DeepSeekMoE và sử dụng huấn luyện Multi-Token Prediction (MTP) để tăng tốc quá trình đào tạo.

Thứ hai, các kỹ sư của DeepSeek tạo nên framework dùng để huấn luyện tên là HAI-LLM có thể tận dụng tối ưu hạ tầng trong tay. Họ sắp xếp việc tính toán và truyền dữ liệu một cách hợp lý để GPU không có thời gian nghỉ. Việc truyền dữ liệu giữa các GPU trong một node và giữa các nodes với nhau cũng được tính toán làm sao cho sử dụng hết băng thông NVLink (giữa các GPU trong một node) và InfiniBand (giữa các nodes với nhau).

Bên cạnh đó, các mô hình LLM thường được huấn luyện với độ chính xác FP16 (sử dụng 16 bit để lưu trữ trọng số) nhưng framework của DeepSeek kết hợp linh hoạt giữa FP8, BP16, và FP32, tuỳ thuộc vào yêu cầu tính toán, giúp giảm chi phí lưu trữ và vận hành.

Kết quả là, DeepSeek chỉ tốn khoảng 5,576 triệu USD để huấn luyện mô hình V3, thấp hơn nhiều so với mức 40-200 triệu USD mà các công ty AI Mỹ chi cho mô hình LLM của họ.

Ngoài ra, các mô hình LLM của Trung Quốc thường tập trung vào các tác vụ chuyên biệt thay vì giải quyết nhiều tác vụ như các mô hình của OpenAI. Ví dụ, DeepSeek-R1 nổi bật trong suy luận, trong khi các mô hình của OpenAI giải quyết đa dạng hơn.

Founder DeepSeek Lương Văn Phong là ai?

Nhà sáng lập DeepSeek Lương Văn Phong (Liang Wenfeng) - Ảnh: Getty Images

Founder DeepSeek Lương Văn Phong (Liang Wenfeng) được xem như người hùng tại Trung Quốc. Khi vị doanh nhân 8x này về quê đón Tết, một đám đông đã tụ tập quanh nhà ông, trong đó có nhiều bậc phụ huynh dẫn theo con nhỏ, hy vọng chúng sẽ lấy founder DeepSeek làm tấm gương noi theo.

Sinh năm 1985, vị doanh nhân quê Quảng Đông, Trung Quốc, thể hiện sức học vượt trội từ khi còn nhỏ.

Theo Wall Street Journal, thời còn đi học, founder DeepSeek là học sinh giỏi toàn diện ở trường. Trong khi, tờ Financial Times dẫn lời người dân địa phương cho biết, khi còn nhỏ anh là "học sinh giỏi nhất", hay đọc truyện tranh và giỏi toán.

Sau khi tốt nghiệp phổ thông, ông Phong theo học tại Đại học Chiết Giang, chuyên ngành Kỹ thuật Điện tử và Truyền thông trước khi theo học chương trình thạc sĩ Kỹ thuật Thông tin và Truyền thông. Năm 2010, ông tốt nghiệp với luận án về cải thiện hệ thống giám sát AI.

Năm 2015, ở tuổi 30, chàng trai quê Quảng Đông thành lập quỹ đầu cơ High-Flyer, đặt mục tiêu sử dụng toán học và AI để mang lại kết quả đầu tư vượt trội. Đến tháng 7/2023, ông thành lập DeepSeek, hướng sự quan tâm mạnh mẽ hơn đến lĩnh vực AI.

Giống các công ty khởi nghiệp AI khác, DeepSeek cũng đã phát triển và thử nghiệm nhiều mô hình AI khác nhau, nhưng không thực sự tạo được sự chú ý, cho đến khi phiên bản R1 gây tiếng vang.

DeepSeek còn sử dụng mã nguồn mở, khác với đối thủ OpenAI của Mỹ.

Chủ trương này có lẽ bắt nguồn từ quan điểm của nhà sáng lập Lương Văn Phong. Ông từng chia sẻ với truyền thông rằng: "Ngay cả khi OpenAI là mã nguồn đóng, nó vẫn không thể ngăn cản những công ty khác bắt kịp... Mã nguồn mở giống như một hoạt động văn hóa hơn là một hoạt động kinh doanh... một công ty thực hiện điều này sẽ có được sức mạnh mềm”./.